NEWSLETTER ABONNIEREN

Sie interessieren sich für die Projekte und Ergebnisse unserer Zukunftslabore? Unser Newsletter fasst die wichtigsten Ereignisse alle zwei Monate zusammen.

Jetzt anmeldenFlüsse können bei starkem Regen schnell über die Ufer treten und Schäden durch Überschwemmungen verursachen. Solche Ereignisse frühzeitig zu erkennen, ist wichtig für ein vorausschauendes Katastrophenmanagement. Eine kontinuierliche Überwachung von Gewässern durch Sensorik kann dabei helfen, solche Entwicklungen früh zu erkennen. Sensoren sind aber nicht flächendeckend verfügbar, sodass es andere Lösungsansätze braucht.

Die Wissenschaftler*innen des Zukunftslabors Wasser forschen an einer neuen Idee: Bürger*innen fotografieren Flüsse, z. B. auf dem Weg zur Arbeit oder bei einem Spaziergang, und unterstützen so das Umweltmonitoring. Denn diese Aufnahmen liefern wertvolle Informationen über die Höhe des Wasserstandes, ebenso über Verschmutzungen oder Bewuchs.

Citizen Science an Flüssen in Hannover

Um diesen Lösungsansatz zu untersuchen, führen die Wissenschaftler*innen ein Citizen-Science-Projekt an den Flüssen Leine und Ihme in Hannover durch. Citizen Science bedeutet in diesem Zusammenhang, dass Bürger*innen ihre Fotos für die Forschungszwecke des Zukunftslabors zur Verfügung stellen. Hierfür installierten die Wissenschaftler*innen Smartphone-Halterungen an der Stockmannbrücke an der Leine und an der Benno-Ohnesorg-Brücke an der Ihme. Bürger*innen können ihre Smartphones in die Halterungen klemmen und Fotos der Flüsse aufnehmen. Eine Informationstafel erklärt das Projekt und den Upload der Fotos in eine Cloud. Die Wissenschaftler*innen entschieden sich bewusst für diese beiden Testregionen, da sich die Umgebungen stark voneinander unterscheiden. Das Gebiet an der Stockmannbrücke liegt in einem recht natürlichen Umfeld, das kaum bebaut ist und hauptsächlich von Fußgänger*innen und Radfahrer*innen besucht wird. Die Benno-Ohnesorg-Brücke liegt hingegen im Stadtzentrum Hannovers, also in einer sehr belebten Umgebung mit vielen Gebäuden in der Nähe.

Wir interessieren uns hierbei vor allem für einen Aspekt: Um die Fotos der Bürger*innen auswerten zu können, sind Referenzpunkte erforderlich – also Orientierungspunkte in der Umgebung eines Flusses, anhand derer Veränderungen des Wasserstandes verglichen werden können. In der natürlichen Umgebung der Stockmannbrücke gibt es wenige Referenzpunkte, im Stadtzentrum dafür umso mehr. Durch die beiden Testregionen decken wir also beide Fälle ab.

Für die Datenauswertung ist noch ein weiterer Aspekt wichtig: die Pose, aus der die Fotos aufgenommen werden, da je nach Pose der gleiche Wasserstand unterschiedlich wirken kann. Die Pose ist eine Kombination aus der Position (Wo ist die Kamera zum Zeitpunkt der Aufnahme?) und der Rotation (Und wie ist sie gedreht?). Wenn die Smartphones in die hierfür vorgesehenen Halterungen geklemmt und dann Fotos gemacht werden, ist die Pose immer gleich. Aber diese Halterungen gibt es zu selten, sodass auch Fotos analysiert werden müssen, die aus verschiedenen Posen aufgenommen wurden. Je genauer die Pose bestimmt wird, desto besser können die Fotos miteinander verglichen und der tatsächliche Wasserstand ermittelt werden.

Neue Technik: 3D Gaussian Splatting Environments

Hier kommt eine moderne Technik zur Darstellung von 3D-Szenen ins Spiel: 3D Gaussian Splatting. Dabei werden Millionen von 3D-Gauss-Verteilungen – kleine, unscharfe Blobs oder Punkte – genutzt, um eine realistische Rekonstruktion einer Szene zu erzeugen. Jeder dieser Blobs verfügt über eine ganze Palette an Farben, die abhängig vom Blickwinkel ausgetauscht werden können. Dadurch können auch Reflexionen und Transparenzen dargestellt werden.

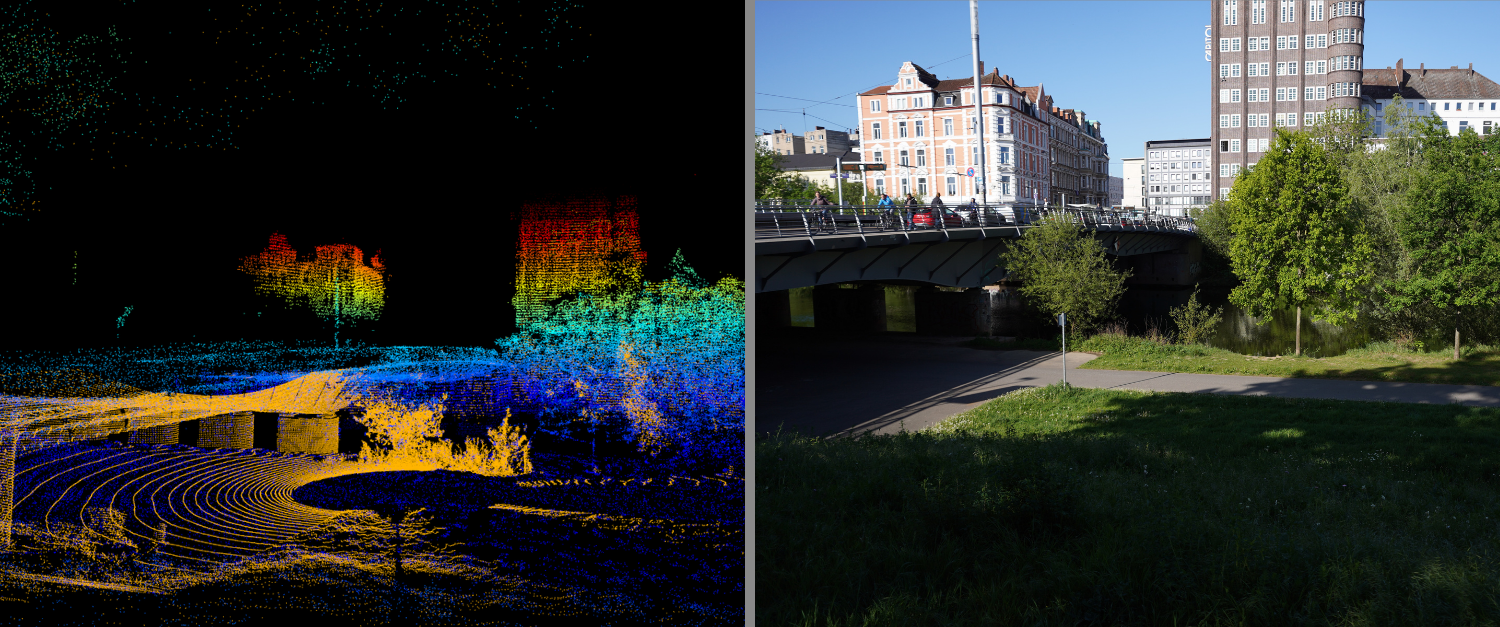

Dieses Verfahren testeten die Wissenschaftler*innen zunächst an zwei weniger komplexen Umgebungen: in ihrem eigenen Büro und in einer Tiefgarage. Für die Erstellung der 3D Gaussian Splatting Environments verwendeten die Wissenschaftler*innen Kameras, in Zukunft werden auch LiDAR-Scanner (Light Detection and Ranging) eingesetzt. LiDAR-Scanner nutzen Laserstrahlen, um präzise Tiefen- und Entfernungsdaten zu erfassen. Kameras liefern Informationen über Farben, Lichtstimmungen und Oberflächenstrukturen. Diese Informationen sind wichtig, um die rekonstruierten 3D-Szenen möglichst naturgetreu und anschaulich darzustellen.

So entstanden 3D-Visualisierungen des Büroraums und der Tiefgarage. In diesen virtuellen Umgebungen platzierten die Wissenschaftler*innen zufällig virtuelle Kameras und extrahierten deren Blickwinkel (Was sehen die Kameras aus ihrer Pose?). Diese Blickwinkel glichen sie mit Fotos der Umgebungen ab. Je näher das virtuelle Kamerabild dem Originalfoto war, desto wahrscheinlicher war es, dass die Fotos aus dieser Pose heraus aufgenommen wurden. Somit näherten sich die Wissenschaftler*innen iterativ an die Bestimmung der Kamerapose an.

Ausblick: Wie geht es weiter?

Die bisherigen Experimente im Bürogebäude und in der Tiefgarage lieferten vielversprechende Ergebnisse, sodass die Wissenschaftler*innen zukünftig auch für die Umgebungen an der Leine und der Ihme 3D Gaussian Splatting Environments erstellen werden. Ihr Ziel ist es, die Posen der Kameras so genau zu erfassen, dass der Wasserstand auf 10 Zentimeter genau abgeglichen werden kann.