NEWSLETTER ABONNIEREN

Sie interessieren sich für die Projekte und Ergebnisse unserer Zukunftslabore? Unser Newsletter fasst die wichtigsten Ereignisse alle zwei Monate zusammen.

Jetzt anmeldenDie Gesichtserkennung von Smartphones bietet viele nützliche Vorteile: Zum einen dient sie als schnelle und einfache Möglichkeit, das Gerät zu entsperren, ohne Passwörter oder Muster einzugeben. Zum anderen kann sie zum automatischen Sortieren und Auffinden von Bildern genutzt werden, auf denen Menschen abgebildet sind. Diese Funktionen basieren auf Maschinellem Lernen (ML), mit dem Gesichter analysiert und Muster erkannt werden. Die Anbieter von Smartphone-Anwendungen nutzen dafür eine spezielle Form von ML, das Föderierte Lernen (FL). Dabei werden die ML-Modelle lokal auf den Geräten angewendet, statt diese wie in klassischen ML-Anwendungen in einem zentralen Serversystem zu analysieren. Die trainierten ML-Modelle werden dann an einen zentralen Server geschickt und dort zur Erstellung eines gemeinsamen Modells genutzt, welches wiederum auf die Smartphones gespielt wird. Auf diesem Wege werden keine sensiblen Daten (wie z. B. Fotos) ausgetauscht und trotzdem die ML-Modelle auf den Smartphones verbessert.

Dieses Prinzip machte sich das Zukunftslabor Produktion bei der Entwicklung einer Datenaustauschplattform zunutze. Das beispielhafte Anwendungsszenario des Zukunftslabors ist der Aluminiumdruckguss, bei dem verschiedene Unternehmen Hand in Hand arbeiten. Zweck der Plattform ist es, Informationen der Produktion entlang der Lieferkette standort- und unternehmensübergreifend zu analysieren. Ziel ist es, Prozesse effizienter zu gestalten und die Ursache für Produktionsfehler zu ermitteln oder vorab zu verhindern.

Technische Finalisierung der Datenplattform

In den vergangenen Forschungsjahren hatten die Wissenschaftler*innen die Datenplattform Schritt für Schritt aufgebaut, 2024 integrierten sie die letzten fehlenden Komponenten. Dazu zählt die Connector-Funktion, die für die Kommunikation und den Datenaustausch zwischen den beteiligten Geräten, Knoten oder Clients im Netzwerk verantwortlich ist. Daraufhin haben die Wissenschaftler*innen ein Informationsmodell zur digitalen Abbildung der Lieferkette eingebunden, das definiert, wie die Daten in der dezentralen Plattform organisiert, strukturiert und miteinander in Beziehung gesetzt sind. Die über dieses Modell verbundenen Edge-Datenplattformen dienen als Blaupause für die Datenorganisation. Die Edge-Plattform legt dabei fest, welche Datenarten gespeichert werden können, welche Eigenschaften sie haben und wie diese innerhalb des Unternehmens miteinander verknüpft sind. Außerdem integrierten die Wissenschaftler*innen Dienste auf Basis des Föderierten Lernens für ein souveränes Kommunikationsszenario. Unternehmen, die die Plattform nutzen, können darüber bei den anderen Unternehmen Informationen anfragen. Die anderen Unternehmen können selbstständig entscheiden, welche Daten sie zur Verfügung stellen wollen.

Die Wissenschaftler*innen definierten in einem Benutzerkonzept auch die User-Typen der Datenplattform und deren Aufgaben. Der Basis-User z. B. kann eine Datenabfrage stellen, während der Data Engineer Ergebnisse aus den Unternehmensdaten bereitstellen kann. Der Learning Administrator ermittelt die Wissensziele des Unternehmens und wandelt diese in Abfragestrukturen um. Der Supply Chain Administrator kann neue Unternehmen der Lieferkette hinzufügen und in die Datenstruktur aufnehmen. Der Security Administrator ist für die Sicherheit der gesamten IT-Infrastruktur einer Datenplattform verantwortlich, einschließlich der Verwaltung des Benutzerzugriffs, der Implementierung und Überwachung von Sicherheitsrichtlinien und der Reaktion auf Sicherheitsvorfälle. Zudem definierten die Wissenschaftler*innen die Schnittstellen zwischen den Usern und ihre Berechtigungen, damit es keinen Multi-User mit allumfänglichen Rechten gibt.

Zwei Anwendungsfälle zum Testen der Plattform

Um die Datenplattform zu testen, überführten die Wissenschaftler*innen Daten aus dem Aluminiumdruckgussprozess in die Plattform. Dafür nutzten sie ein Edge Device, das die Daten direkt an den Produktionsanlagen verarbeitet, anstatt sie zur Analyse an zentrale Server zu senden. Dadurch werden die Latenzzeiten reduziert, die Abhängigkeit von Internetverbindungen wird verringert und die Datensicherheit wird verbessert, da sensible Informationen lokal verarbeitet werden. Auf Basis der überführten Produktionsdaten folgten zwei erfolgreiche Analysen: Bei der ersten Analyse wurden unternehmensübergreifende Daten aus der Lieferkette des Aluminiumdruckgusses in Hinblick auf Produktionsfehler untersucht. Die Auswertung zeigte, dass das Konzept des Föderierten Lernens zur unternehmensübergreifenden Fehlererkennung geeignet ist und somit einen hohen Nutzen für die Lieferkette bietet. Allerdings stellten die Wissenschaftler*innen auch fest, dass das Ergebnis der Datenanalyse aufgrund des dezentralen FL-Ansatzes schlechter ist als bei einem zentralen Ansatz, bei dem alle Daten auf einem Server analysiert werden. Dafür gewährleistet das Konzept des föderierten Lernens aber die Datensouveränität der beteiligten Unternehmen.

Bei der zweiten Analyse prüften die Wissenschaftler*innen, ob die FL-basierte Datenplattform aus dem Aluminiumdruckguss auf ein anderes Produktionsverfahren – den Kunststoffspritzguss – übertragen werden kann. Dafür stellten die Wissenschaftler*innen Bauteile mit dem Kunststoffspritzgussverfahren her und analysierten den Werkzeugverschleiß mithilfe eines Regressionsmodells. Dieses Modell ermittelt den Zustand des Werkzeuges und prüft, ob der Verschleiß aufgrund eines Bedienungsfehlers oder eines Werkzeugfehlers entstanden ist. Es zeigte sich, dass die Plattform des Zukunftslabors für diesen Anwendungsfall eingesetzt werden kann, um die Daten zu analysieren.

Darüber hinaus verglichen die Wissenschaftler*innen in einer Feldstudie verschiedene Anwendungsbibliotheken des Föderierten Lernens. Dabei handelt es sich um spezialisierte Softwarebibliotheken oder Frameworks, die Entwickler*innen die Implementierung, Verwaltung und Optimierung von föderierten Lernprozessen erleichtern. Alle untersuchten Anwendungsbibliotheken eignen sich für den Anwendungsfall des Aluminiumdruckgusses. Die Wissenschaftler*innen entschieden sich im Projekt für die Nutzung des Frameworks Flower, das sich vor allem durch die Integrationsmöglichkeiten in lieferkettenartige Umgebungen ohne Nutzung eines Mediators auszeichnet. Zudem verfügt das Framework bereits über eine ausgedehnte Basis an Analysemodellen für vertikales Föderiertes Lernen, das eine Lieferkette am besten abbildet.

Übertragung auf industrielle Datenräume und Datenökosysteme

Die Nutzung der Datenplattform in verschiedenen Kontexten ist den Wissenschaftler*innen wichtig, um sie für möglichst viele Gebiete einsetzen zu können. In diesem Zuge untersuchten sie, ob die entwickelten Anwendungen und Architekturmuster zukünftig in industrielle Datenräume und Datenökosysteme integriert werden können. Zum einen untersuchten sie die Anschlussfähigkeit an die europäische Initiative GAIA-X, die eine sichere, transparente und interoperable digitale Infrastruktur aufbauen möchte. GAIA-X bietet in Form eines digitalen Katalogs eine Übersicht, welche Daten im Ökosystem vorhanden sind – ähnlich einer Google-Suche im Internet. Damit die Daten aus der Plattform des Zukunftslabors ebenfalls über diesen Katalog gefunden werden können, integrierten die Wissenschaftler*innen einen Data Space Connector in die Plattform, mit dem eine Verbindung zum GAIA-X-Katalog hergestellt werden kann.

Zum anderen prüften sie die Vernetzung mit dem Projekt „Europäisches Produktionsgiganet (EuProGiant)“, welches ein vernetztes Produktionsökosystem schaffen will, das datenbasiert, widerstandsfähig und nachhaltig ist. Hierfür machten die Wissenschaftler*innen die Datenplattform des Zukunftslabors für die Servicestruktur von EuProGiant zugänglich – ähnlich wie bei GAIA-X, nur mit einem anderen Modell. Beide Vorhaben waren erfolgreich und zeigten, dass die Datenplattform des Zukunftslabors für industrielle Datenräume und Datenökosysteme nutzbar ist.

Die Integration von Föderiertem Lernen in industrielle Datenökosysteme ermöglicht Datensouveränität in einem offenen System, in dem Zulieferer ohne aufwendige Anforderungen eingebunden werden können. Dadurch können sensible Informationen mit offenen Daten kombiniert und somit die Analysequalität weiter verbessert werden. Zudem vereinfacht die Nutzung eines Datenökosystems die automatisierte Integration von Datenquellen, was den Aufwand manueller Integration neuer Partner reduziert und die Plattform leichter zugänglich macht.

IT-Sicherheitskonzept gemäß Sicherheitsrichtlinien

Um die Datenplattform vor Cyberangriffen abzusichern, entwickelten die Wissenschaftler*innen ein umfangreiches Konzept zur IT-Sicherheit. Dabei berücksichtigten sie sowohl die deutsche Richtlinie für Anwendungen in der Industrie, die VDI/VDE 2182 – Blatt 1, als auch die internationale Industrienormenreihe IEC 62443.

Die Richtlinie VDI/VDE 2182 – Blatt 1 stellt ein Konzept für ein strukturiertes Vorgehen zur Risiko- und Gefährdungsbeurteilung bereit. Sie ist speziell für Unternehmen in der Industrie und im produzierenden Gewerbe konzipiert und stellt eine praxisnahe Anleitung für die Implementierung und Aufrechterhaltung von IT-Sicherheitsmaßnahmen bereit. Dabei nutzt sie ein iteratives Sicherheitskonzept, das insgesamt sieben Stufen umfasst und von den Wissenschaftler*innen des Zukunftslabors angewendet wurde: Aufbauend auf einer initialen Strukturanalyse der Datenplattform (Schritt 0) identifizierten die Wissenschaftler*innen die zentralen Assets, also Komponenten, Ressourcen und Informationen der Plattform, die für den Betrieb und die Sicherheit wesentlich sind und daher geschützt werden müssen (Schritt 1). Daraufhin analysierten sie mögliche Bedrohungen (Schritt 2) und ermittelten relevante Schutzziele (Schritt 3). Im vierten Schritt analysierten und bewerteten die Wissenschaftler*innen mögliche Risiken und im fünften Schritt zeigten sie passende Schutzmaßnahmen auf, einschließlich der Bewertung ihrer Wirksamkeit. Daraufhin wählten sie geeignete Schutzmaßnahmen aus (Schritt 6). Schritt 7 beinhaltet das Prozessaudit, bei dem die einzelnen Prozesse hinsichtlich Änderungen oder neu eingebrachter Assets untersucht und überprüft werden. Sollte dies der Fall sein, beginnt die Iteration (Schritt 1 bis 7) von vorn.

Ein Beispiel veranschaulicht dieses iterative Sicherheitskonzept: Bei der initialen Strukturanalyse (Schritt 0) untersuchten die Wissenschaftler*innen die Softwarekomponenten der Datenplattform. Sie identifizierten das AlmaLinux-Betriebssystem als ein zu untersuchendes Asset (Schritt 1) und analysierten mögliche Bedrohungen (Schritt 2), wobei sie Schwachstellen in der Konfiguration entdeckten. Dabei handelt es sich um veraltete Softwarepakete, die Sicherheitslücken offenbaren und unbefugten Zugriff ermöglichen können. Relevante Schutzziele (Schritt 2) sind in diesem Fall Authentizität, Vertraulichkeit und Verfügbarkeit. Bei der Risikoanalyse- und bewertung (Schritt 4) stuften die Wissenschaftler*innen das Schadensmaß der Schwachstellen auf einer Skala von 0 bis 10 (10 ist das höchste Schadensmaß) auf 8 ein. Die Eintrittswahrscheinlichkeit für Angriffe bewerteten sie auf einer Skala von 0 bis 3 (3 bedeutet eine sehr hohe Eintrittswahrscheinlichkeit) mit 2. Daraus resultierte ein Risiko von 16 (Produkt aus 8 und 2). Als Schutzmaßnahmen (Schritt 5) identifizierten die Wissenschaftler*innen die Implementierung eines Patch-Management-Systems (Software, die rechtzeitig Updates installiert), regelmäßige Sicherheitsüberprüfungen, tägliche Backups sowie einen Antivirus-Scan. Bei der Auswahl der Schutzmaßnahmen (Schritt 6) bewerteten die Wissenschaftler*innen die Maßnahmen anhand von Kosten/Aufwand und Effektivität. In diesem Beispiel bestand ein mittlerer Aufwand und eine hohe Effektivität, weshalb die Maßnahmen umgesetzt wurden. Die Überprüfung der eingesetzten Schutzmaßnahmen (Schritt 7) zeigte, dass das Schadensmaß von 8 auf 7 sank und die Eintrittswahrscheinlichkeit von 2 auf 1. Das Risiko wurde demnach von 16 auf 7 reduziert.

Forschung und Innovation gehen im Bereich der Cybersicherheit Hand in Hand. Unsere Datenplattform zeigt, wie moderne Sicherheitskonzepte in digitale Lösungen integriert werden können, um die Unternehmen einer Wertschöpfungskette umfassend zu schützen. Die Plattformvereint digitale Vernetzung mit innovativen Sicherheitsstrategien, um gegen potenzielle Angriffe gewappnet zu sein.

Risikoanalyse auf Basis internationaler Normen und mithilfe spezieller Software

Im internationalen Kontext spielt die Norm IEC 62443-3 eine wichtige Rolle hinsichtlich der Cybersicherheit industrieller Automatisierungssysteme. Die Wissenschaftler*innen analysierten die Sicherheit der Datenplattform unter Berücksichtigung der Teile IEC 62443-3-2 und IEC 62443-3-3. Der zweite Teil der Norm (IEC 62443-3-2) beschreibt den Prozess der Risikobewertung und die Entwicklung eines Sicherheitsplans für industrielle Automatisierungssysteme, ähnlich wie VDI/VDE 2182 – Blatt 1. Dies unterstützt Unternehmen dabei, ein Sicherheitskonzept zu entwickeln, das auf den spezifischen Bedrohungen und Schwachstellen ihrer Systeme basiert. Der dritte Teil der Norm (62443-3-3) legt detaillierte technische Sicherheitsanforderungen fest, die für industrielle Automatisierungssysteme gelten. Dadurch soll sichergestellt werden, dass die industriellen Systeme durch robuste Sicherheitsmechanismen geschützt werden.

Darüber hinaus ermittelten die Wissenschaftler*innen potenzielle Sicherheitsbedrohungen, wobei sie das Microsoft Threat Modelling Tool unterstützte. Hierfür entwickelten die Wissenschaftler*innen ein Modell der Datenplattform, das sie mithilfe des Tools überprüften. Auf diese Weise identifizierten die Wissenschaftler*innen standardmäßige Angriffsvektoren, die in ihre Risikobeurteilung einflossen. Des Weiteren bietet das Tool den Vorteil, automatisch Berichte zu erstellen und den Abarbeitungsstatus möglicher Angriffsvektoren zu dokumentieren.

Umsetzung der Sicherheitsmaßnahmen im Rahmen eines Minimum Viable Products (MVP)

In den vergangenen Jahren hatten die Wissenschaftler*innen bereits ein sicherheitsbasiertes MVP aufgesetzt. Ein MVP ist eine erste Version eines Produkts, die mit den minimal notwendigen Funktionen ausgestattet ist, um für die Datenplattform sicherheitsrelevante Implementierungen zu testen. Im Forschungsjahr 2024 setzten die Wissenschaftler*innen die Sicherheitsmaßnahmen, die aus der Risiko- und Gefährdungsbeurteilung resultierten, auf dem MVP um. Außerdem führten sie Performance-Tests durch. Ein Performance-Test konzentriert sich auf die Leistungsfähigkeit einer Datenplattform. Ziel ist es, sicherzustellen, dass das System unter verschiedenen Lastbedingungen zuverlässig funktioniert. Der Test ergab, dass die Performance des MVP durch die Sicherheitsmaßnahmen kaum und in vertretbarem Maße eingeschränkt ist. Ein Penetrationstest steht aktuell noch aus. Dabei werden simulierte Angriffe auf eine Datenplattform durchgeführt, um Schwachstellen und Sicherheitslücken zu identifizieren.

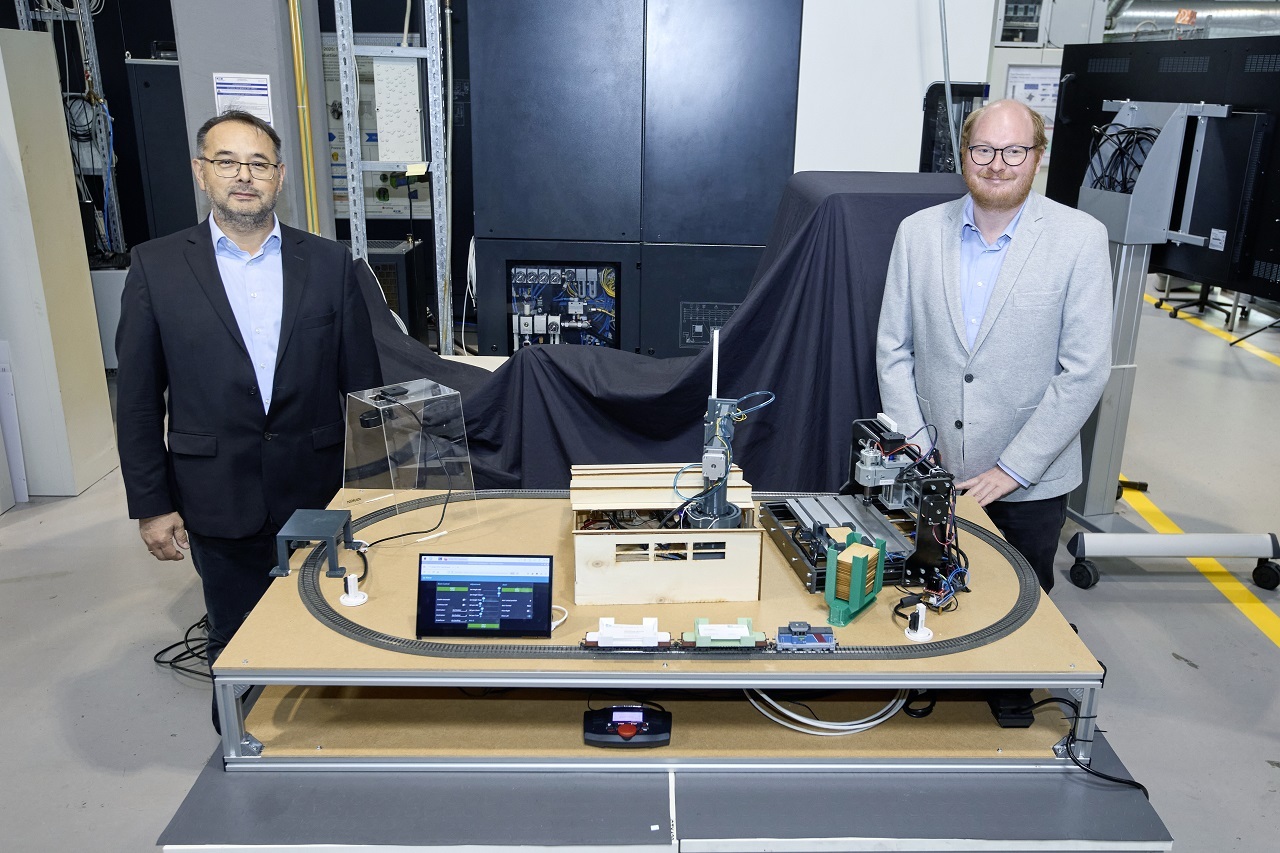

Demonstrator einer Lieferkette: Sensorik zur frühzeitigen Fehlererkennung

Im Forschungsjahr 2023 hatten die Wissenschaftler*innen mit dem Bau eines Demonstrators begonnen, der auf einfache Weise eine Lieferkette abbildet, an der mehrere Unternehmen beteiligt sind. Eine Miniaturfabrik auf einer Holzplatte demonstriert die digitale Fertigung einer NC-fähigen Visitenkarte: Ein Holzstück wird per Eisenbahn zu einer CNC-Fräse transportiert und dort graviert. Zusätzlich werden über einen Scanner die Kontaktinformationen einer haptischen Visitenkarte erfasst und in eine virtuelle Visitenkarte überführt. Die Daten aus der virtuellen Visitenkarte werden auf einen Chip übertragen, der sich in dem Holzstück befindet. Über ein Lesegerät können die Daten wie bei einer Bankkarte ausgelesen werden. Im Forschungsjahr 2024 fügten die Wissenschaftler*innen Sensoren zur frühzeitigen Fehlererkennung hinzu. Physische Sensoren an den Transportschienen lokalisieren die Position der Lok, womit Fehler der Logistiksteuerung festgestellt werden können. Virtuelle Sensoren prüfen, ob die Gravur und die Datenübertragung korrekt erfolgen. Werden Fehler erkannt, kann der Vorgang korrigiert oder neu gestartet werden. Der Demonstrator ist transportierbar und kann auf Veranstaltungen und Messen präsentiert werden.